在深度学习领域,模型的部署一直是一个具有挑战性的任务。为了解决这个问题,OpenMMLab推出了MMDeploy,一个强大而灵活的工具,帮助用户轻松地将他们的模型部署到不同的平台和推理引擎上。本文将带您深入了解MMDeploy的功能和最新进展,让您在模型部署的道路上游刃有余!

时间如白驹过隙,转眼间MMDeploy已经陪伴大家走过一个季度了。在过去的几个月里,MMDeploy不仅积极进行了功能扩展,还提供了详细的模型部署教程。让我们来看看最新的进展吧!

- 设备支持:MMDeploy现在集成了NVIDIA Jetson系列,为用户提供了更多的选择。如果您对此感兴趣,可以查看安装说明手册。

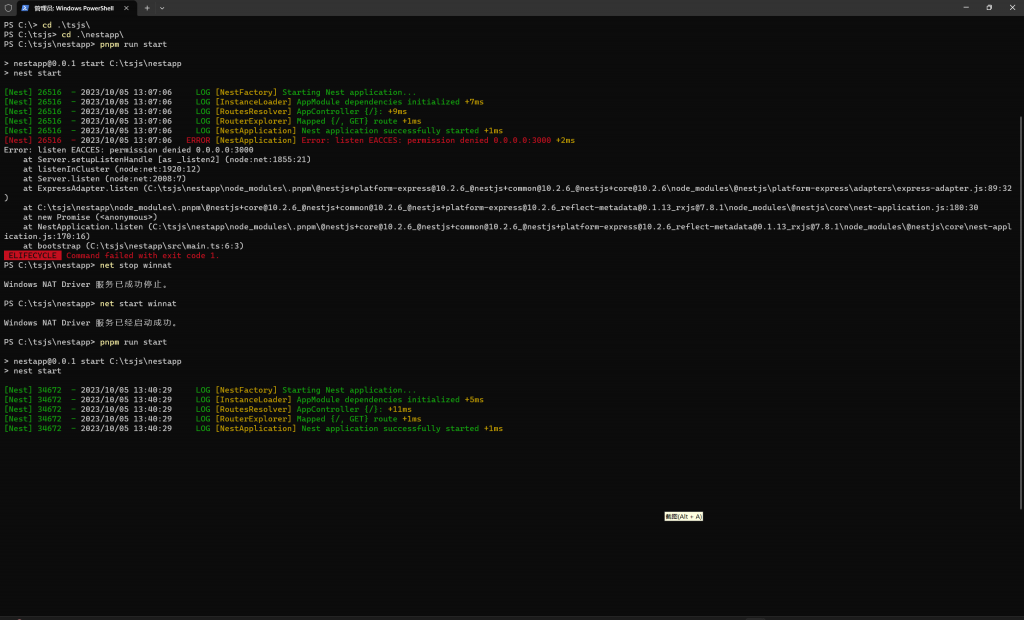

- 平台支持:MMDeploy现在也支持Windows平台。这项工作的完成超出了预期,经历了各种挑战和困难。在此,我们要特别感谢社区同学对文档的审阅工作。另外,MMDeploy还支持了Android平台,并开发了相应的演示Demo。您可以通过链接观看这个Demo的视频。

- FFI封装:MMDeploy现在提供了Python接口,让Python爱好者能够轻松地进行模型推理。只需几行代码,即可完成模型的推理过程。在下面的章节中,我们将提供具体的例子供您参考。目前,MMPose和MMDetection3D也得到了算法库的支持,用户可以体验相关功能。

- 新的IR支持:MMDeploy现在支持TorchScript,这是PyTorch的一种中间表示格式。如果您对TorchScript还不太了解,可以通过链接了解更多信息。关于如何使用TorchScript和ONNX,我们将在后续的教程中进行介绍。教程和技术文档的更新将在我们的微信公众号和知乎账号上发布,欢迎大家关注。

使用MMDeploy的方法非常灵活。您可以将其作为一个整体来完成端到端的模型部署,也可以只使用其中的部分功能模块,根据自己的项目需求灵活选择。例如:

- 使用Model Converter进行模型转换和推理。这适用于快速搭建模型部署的演示和验证工作。只需提供相应的配置、算法和模型文件,通过一条命令将PyTorch模型转换为所需的推理引擎格式。目前,MMDeploy支持6种推理引擎:TensorRT、ONNXRuntime、PPL.NN、ncnn、OpenVINO和libtorch。

- 将MMDeploy算子库集成到自己的项目中。如果您已经集成了TensorRT推理引擎,只需加载MMDeploy算子库,即可无缝读取MMDeploy转换的TensorRT模型。同样,这种方式也适用于ONNXRuntime推理引擎。

- 导出SDK Model,将MMDeploy集成到自己的项目中。这适用于对延迟或吞吐量要求较高的场景。以检测任务为例,您可以选择集成C/C++接口或Python接口。其他任务,如分类、分割、文字检测等,也可以采用相似的方式集成。具体的集成方法和代码示例可以参考本文后续部分。

除了上述典型的应用场景,您还可以基于MMDeploy开发新的模块或组件。比如,您可以开发新的模型导出方法、推理引擎组件、算法的后处理模块,或者支持其他文件格式的读取模块等。通过付诸行动,您可以开源自己的项目,展示自己的才华和创造力。

未来规划方面,MMDeploy团队计划在第二季度继续推出新的功能和更新。具体的计划可以参考下图。最后,我们诚挚地邀请大家多多关注MMDeploy,并加入我们的社群,一起享受愉快的学习和探索过程。我们期待您的关注、点赞和参与!

结语:

MMDeploy是一个强大而灵活的工具,旨在简化深度学习模型的部署过程。通过MMDeploy,您可以选择最适合自己项目需求的部署方式,并轻松地将模型部署到各种平台和推理引擎上。无论您是初学者还是经验丰富的研究者,MMDeploy都能为您带来便利和效率。让我们一起探索MMDeploy的世界,让深度学习变得更简单!