近年来,大型语言模型(LLM)在各个领域都取得了显著的进步,其强大的文本理解和生成能力令人惊叹。那么,LLM 是否能胜任模拟文本世界的任务呢?换句话说,能否利用 LLM 来构建虚拟环境,并准确预测行动对世界状态的影响,从而省去繁琐的人工编码?

本文将探讨 LLM 作为文本世界模拟器的潜力,并通过一个名为 BYTESIZED32-State-Prediction 的全新基准数据集进行评估。

模拟世界的挑战

模拟世界对于理解和研究世界至关重要,但传统上,构建一个复杂的模拟环境需要大量的人工投入,耗费大量时间和精力。LLM 的出现为我们提供了一种新的思路,即利用其庞大的预训练数据集,直接将其作为模拟器使用。

然而,LLM 真的能胜任模拟器的角色吗?为了回答这个问题,研究人员将目光投向了文本游戏领域。文本游戏以自然语言描述环境和动态变化,长期以来被用于决策过程、信息提取和人工智能推理等研究领域。

两种利用 LLM 进行世界建模的方法

研究人员提出两种利用 LLM 进行世界建模和模拟的方法:

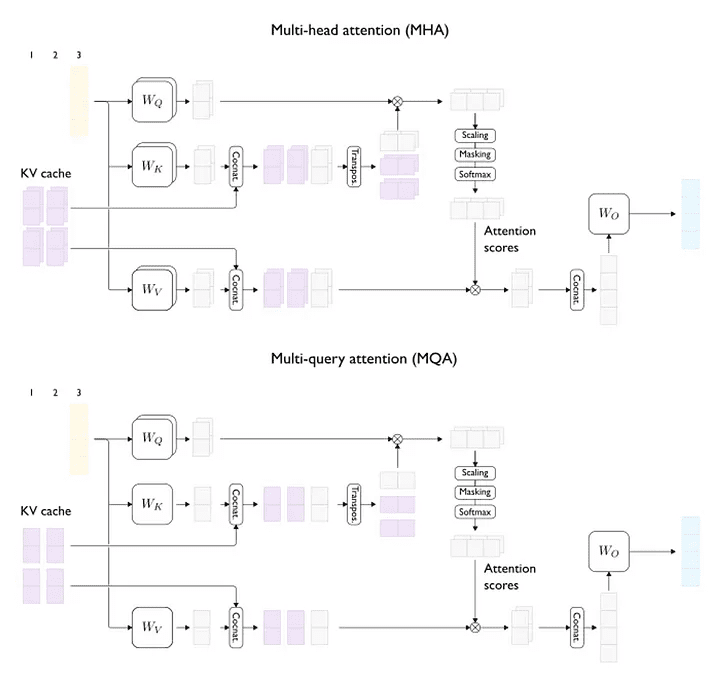

- 神经符号方法: 利用 LLM 生成符号表示的代码,以便进行形式化规划或推理。例如,REASONING VIA PLANNING (RAP) 方法利用 LLM 的先验知识构建世界模型,然后使用专门的规划算法来决定代理策略。

- 直接模拟方法: 利用 LLM 直接生成文本描述,构建虚拟环境,并根据用户输入的行动进行模拟。例如,AI-DUNGEON 项目使用 LLM 生成文本描述,构建一个纯粹由语言模型驱动的游戏世界。

本文重点关注第二种方法,即直接模拟方法,并首次对 LLM 直接模拟虚拟环境的能力进行了量化分析。

BYTESIZED32-State-Prediction 基准数据集

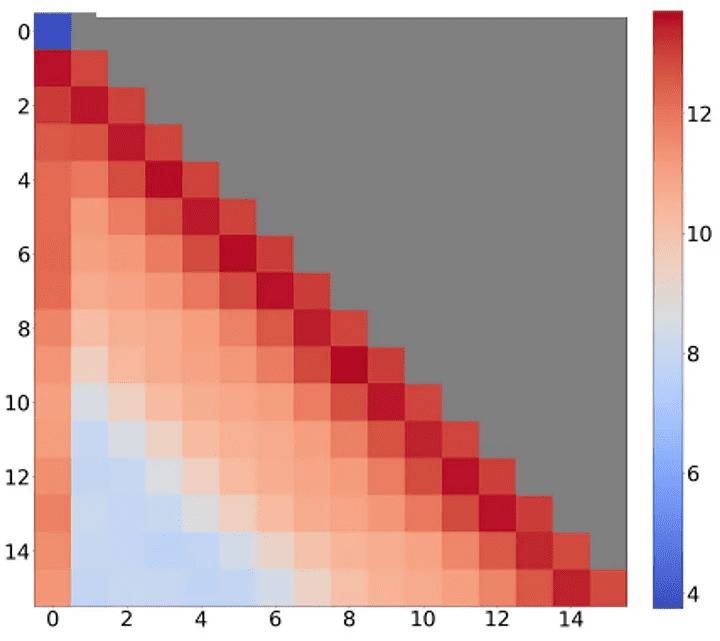

为了评估 LLM 作为文本世界模拟器的能力,研究人员构建了一个名为 BYTESIZED32-State-Prediction (BYTESIZED32-SP) 的全新基准数据集。该数据集包含 76,369 个文本游戏状态转换,每个转换都由一个七元组 (S, A, T, O, R, C, D) 表示,分别对应状态空间、动作空间、转换函数、观察函数、奖励函数、上下文信息和完成指示函数。

该数据集从 BYTESIZED32 数据集派生而来,BYTESIZED32 数据集包含 32 个由人类编写的文本游戏,每个游戏模拟不同的科学或常识推理概念。研究人员通过修改每个 BYTESIZED32 游戏,使其能够在每个时间步输出游戏状态 (st, rt, dt) 和中间状态 sactt+1,并以 JSON 对象的形式存储。

LLM-Sim 任务

研究人员定义了一个名为 LLM-Sim 的预测任务,用于评估 LLM 作为可靠模拟器的能力。LLM-Sim 任务的目标是实现一个函数 F : C × S × A → S × R × {0, 1},该函数将给定的上下文信息、状态和行动 (c, st, at) 映射到后续状态、奖励和游戏完成状态 (st+1, rt+1, dt+1)。

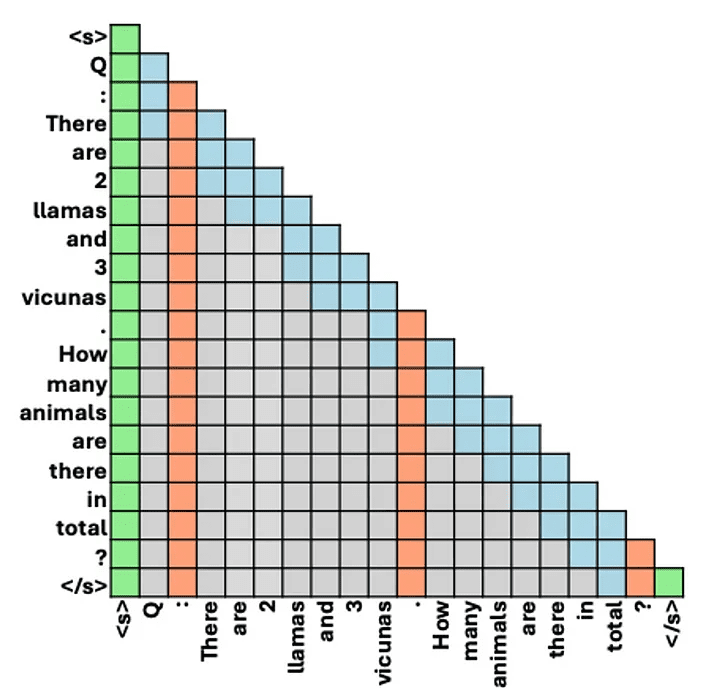

为了更好地理解 LLM 模拟不同类型状态转换的能力,研究人员将模拟函数 F 分解为三个步骤:

- 动作驱动转换模拟器 Fact: 预测给定上下文信息、状态和行动 (c, st, at) 后,状态的直接变化 sactt+1。

- 环境驱动转换模拟器 Fenv: 预测给定上下文信息和动作驱动转换后的状态 (c, sactt+1) 后,环境因素引起的额外状态变化 st+1。

- 游戏进度模拟器 FR: 预测给定上下文信息、状态和行动 (c, st+1, at) 后,游戏的奖励 rt+1 和完成状态 dt+1。

研究人员分别评估了 LLM 模拟 Fact、Fenv 和 FR 的能力,以及模拟完整 F (即包含所有转换) 的能力。

实验结果

研究人员使用 GPT-4 对 BYTESIZED32-SP 数据集进行了评估,结果表明:

- 预测动作驱动转换比预测环境驱动转换更容易: GPT-4 在模拟动态动作驱动转换方面的最佳准确率为 77.1%,而在模拟动态环境驱动转换方面的最佳准确率仅为 49.7%。

- 预测静态转换比预测动态转换更容易: 模拟静态转换比模拟动态转换更容易,因为静态转换只需要判断是否发生状态变化,而动态转换还需要模拟环境因素的影响。

- 预测完整游戏状态对于动态状态更容易,而预测状态差异对于静态状态更容易: 预测动态状态的差异可以显著提高模拟静态转换的性能,但会降低模拟动态转换的性能。

- 游戏规则很重要,LLM 能够生成足够好的游戏规则: 当上下文信息中没有提供游戏规则时,GPT-4 在所有三个模拟任务上的性能都会下降。然而,研究人员没有发现人类专家编写的游戏规则和 LLM 生成的游戏规则之间存在明显的性能差异。

- GPT-4 能够在大多数情况下预测游戏进度: 当上下文信息中包含游戏规则时,GPT-4 能够在 92.1% 的测试用例中正确预测游戏进度。

- 人类在 LLM-Sim 任务上比 GPT-4 表现更好: 研究人员进行了一项初步的人类研究,结果表明,人类在模拟 Fact 方面的准确率为 80%,而 GPT-4 的准确率为 50%。

- GPT-4 在需要算术、常识或科学知识时更容易出错: 研究人员发现,GPT-4 在模拟需要算术、常识或科学知识的动态转换时更容易出错。

结论

进一步的错误分析表明,虽然 LLM 在模拟用户行动的结果方面表现较好,但难以处理环境驱动转换以及需要算术、常识或科学知识的转换。

局限性和伦理问题

本文的研究存在一些局限性和伦理问题:

- 模型选择: 研究人员只评估了 GPT-3.5 和 GPT-4 两种模型,可能存在其他模型在该任务上表现更好。

- 状态表示: 研究人员使用了两种状态表示形式,即完整状态空间和状态差异,可能存在其他更有效的表示形式。

- 领域局限: 本文的研究主要集中在常识和基础科学推理领域,可能无法推广到其他领域,例如物理或医学模拟。

- 伦理风险: LLM 作为文本世界模拟器可能会生成虚假或误导性信息,在某些应用场景中可能存在伦理风险。

未来展望

尽管 LLM 作为文本世界模拟器仍面临挑战,但该领域的研究具有重要的意义,未来需要进一步探索以下方向:

- 提高 LLM 的推理能力: 增强 LLM 对算术、常识和科学知识的理解和运用能力。

- 开发更有效的训练方法: 针对模拟任务,开发专门的训练方法,提高 LLM 的模拟精度。

- 探索新的状态表示形式: 研究更适合模拟任务的新的状态表示形式。

- 关注伦理问题: 在开发和应用 LLM 作为模拟器时,需要充分考虑伦理问题,确保其安全性和可靠性。

参考文献

- Achiam, J., et al. (2023). GPT-4. [Online; accessed 2023-03-14].

- Ammanabrolu, P., & Hausknecht, M. (2020). A text-based adventure game for interactive learning and evaluation of natural language understanding. arXiv preprint arXiv:2005.02294.

- Adhikari, A., et al. (2020). Towards a text-based game for evaluating grounded language understanding. arXiv preprint arXiv:2005.03442.

- Côté, M.-A., et al. (2018). The unreasonable effectiveness of deep learning for text-based games. In Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing (pp. 1830-1839).

- Fan, A., et al. (2020). Learning to play text-based games with a language model. arXiv preprint arXiv:2003.07617.

- Fakhoury, S., et al. (2023). Evaluating the factual consistency of language models. arXiv preprint arXiv:2301.07187.

- Hao, B., et al. (2023). Reasoning via planning: A language model-based approach to symbolic reasoning. arXiv preprint arXiv:2303.16960.

- Hausknecht, M., et al. (2020). A text-based adventure game for interactive learning and evaluation of natural language understanding. arXiv preprint arXiv:2005.02294.

- Jansen, P. (2022). Text-based games for grounded language understanding: A survey. arXiv preprint arXiv:2206.02437.

- Kaelbling, L. P., et al. (1998). Reinforcement learning: A survey. Journal of artificial intelligence research, 8, 237-282.

- Liu, H., et al. (2023). Code as a language: Towards a unified framework for code and natural language. arXiv preprint arXiv:2303.17581.

- Nottingham, W., et al. (2023). Towards general-purpose language models for code generation. arXiv preprint arXiv:2303.16627.

- Shridhar, K., et al. (2020). Text-based adventure games as a testbed for grounded language understanding. arXiv preprint arXiv:2003.04604.

- Tang, Y., et al. (2024). Towards a unified framework for code and natural language via large language models. arXiv preprint arXiv:2401.04156.

- Urbanek, T., et al. (2019). Learning to play text-based games with a language model. arXiv preprint arXiv:1907.03718.

- Valmeekam, V., et al. (2023). Language models are not planners. arXiv preprint arXiv:2303.16487.

- Walton, C. (2020). AI Dungeon: A text adventure powered by GPT-3. [Online; accessed 2023-03-14].

- Wang, R., et al. (2022). A text-based game for evaluating commonsense reasoning in language models. arXiv preprint arXiv:2205.14871.

- Wang, R., et al. (2023). BYTESIZED32: A benchmark for evaluating scientific reasoning in language models. arXiv preprint arXiv:2303.11612.

- Wong, A., et al. (2023). Code as a language: Towards a unified framework for code and natural language. arXiv preprint arXiv:2303.17581.

Q: 这篇论文试图解决什么问题?

A: 这篇论文探讨的主要问题是:当前的语言模型(Language Models,简称LLMs)是否能够作为文本基础的世界模拟器(text-based world simulators),准确地预测动作如何改变不同的世界状态,从而绕过手动编码的需要。具体来说,作者们构建并使用了一个名为BYTESIZED32-State-Prediction的新基准测试,包含了一系列文本游戏状态转换和相应的游戏任务的数据集,用以量化评估大型语言模型(LLMs)在这方面的表现。研究发现,尽管GPT-4等模型表现出色,但如果没有进一步的创新,它们仍然不能作为一个可靠的世界模拟器。这项工作不仅提供了对当前LLMs能力和弱点的新见解,还提供了一个新的基准测试,以跟踪未来模型发展的进步。

Q: 有哪些相关研究?

A: 论文中提到了多项相关研究,主要集中在使用大型语言模型(LLMs)来模拟环境和执行决策任务的领域。以下是一些具体的相关研究:

- Côté et al., 2018: 提出了Textworld,一个用于文本游戏的学习环境。

- Fan et al., 2020: 研究了如何生成交互式世界。

- Urbanek et al., 2019: 研究了在幻想文本冒险游戏中的学习和行动。

- Shridhar et al., 2020: 提出了Alfworld,一个将文本与具身环境对齐的交互式学习平台。

- Hausknecht et al., 2020: 研究了交互式小说游戏。

- Jansen, 2022: 对文本世界进行了系统性的调查。

- Wang et al., 2022: 提出了Scienceworld,一个测试代理是否比五年级学生更聪明的平台。

- Wang et al., 2023: 提出了ByteSized32,一个用于生成特定任务世界模型的文本游戏的语料库和挑战任务。

此外,论文还提到了一些使用语言模型生成代码以进行形式化规划或推理的研究,例如:

- Liu et al., 2023: 研究了如何增强大型语言模型的规划能力。

- Nottingham et al., 2023: 研究了使用语言引导的世界建模来进行具身决策。

- Tang et al., 2024: 提出了Worldcoder,一个通过编写代码和与环境交互来构建世界模型的模型。

这些研究展示了LLMs在不同领域的应用潜力,特别是在模拟环境和决策制定方面。论文通过这些相关工作,为读者提供了一个关于LLMs在文本游戏模拟器领域应用的全面背景。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决这个问题:

- 构建基准测试:作者创建了一个名为BYTESIZED32-State-Prediction的新基准测试,它包含了一系列文本游戏状态转换和相应的游戏任务的数据集。

- 定义预测任务:提出了一个名为LLMas-a-Simulator (LLM-Sim) 的预测任务,用于量化评估语言模型作为可靠模拟器的能力。这个任务涉及从给定的上下文、状态和动作映射到后续状态、奖励和游戏完成状态。

- 分解模拟器功能:将模拟器功能进一步分解为三个步骤:

- 动作驱动的转换模拟器(Fact):预测由动作直接引起的状态变化。

- 环境驱动的转换模拟器(Fenv):预测在动作影响之后,环境如何进一步改变状态。

- 游戏进度模拟器(FR):预测奖励和游戏完成状态。

- 数据收集:从BYTESIZED32语料库中收集数据,该语料库包含32个人工编写的文本游戏,每个游戏都模拟不同的科学或常识推理概念。

- 评估方法:使用提出的基准测试来评估GPT-4模型的性能,通过准确率来衡量模型对状态转换的预测能力。

- 实验和分析:对GPT-4进行系统性分析,发现它在模拟非平凡状态转换时的准确性不超过59.9%。此外,还进行了人类研究,比较了人类注释者和GPT-4在LLM-Sim任务上的表现。

- 结果讨论:论文讨论了GPT-4在模拟任务中的表现,指出了其在模拟环境驱动转换和需要算术、常识或科学知识转换时的不足。

- 结论:基于实验结果,论文得出结论,尽管LLMs在某些方面表现出前景,但目前还不能作为可靠的文本世界模拟器,除非进行进一步的创新。

- 未来工作:论文提出了对未来模型的评估和开发更高性能的语言模型模拟器的期望。

通过这些步骤,论文不仅提供了对当前LLMs能力的深入分析,还为未来的研究提供了一个基准和方向。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验来评估语言模型作为文本世界模拟器的能力:

- LLM-Sim任务评估:提出了LLMas-a-Simulator (LLM-Sim)任务,用于定量评估语言模型作为可靠模拟器的性能。这包括模拟动作驱动的转换(Fact)、环境驱动的转换(Fenv)以及游戏进度(FR)。

- 数据集构建:创建了BYTESIZED32-State-Prediction (BYTESIZED32-SP)数据集,包含76,369个文本游戏状态转换,这些转换是从31个不同的文本游戏中收集的。

- 数据收集方法:从BYTESIZED32语料库中修改游戏,以转储每个时间步的游戏状态,并确定有效的转换。

- 上下文信息:为每个游戏提供了上下文信息,包括动作规则、对象规则、得分规则和示例转换。

- 模型评估:使用GPT-4模型对LLM-Sim任务进行评估,测量其在完整状态预测和状态差异预测两种模式下的准确性。

- 动态与静态转换的比较:分析了模型在模拟动态(状态发生变化)和静态(状态不发生变化)转换时的性能差异。

- 人类与模型性能比较:进行了一项初步的人类研究,让人类注释者模拟Fact任务,并与GPT-4的性能进行了比较。

- 错误分析:对GPT-4在模拟动态转换时的错误模式进行了深入分析,特别是当转换需要算术、常识或科学知识时。

- 游戏进度预测:评估了GPT-4在预测游戏进度方面的能力,包括游戏得分和游戏结束状态。

- 规则的重要性:研究了游戏规则对GPT-4性能的影响,并比较了人类编写的规则和LLM生成的规则。

这些实验提供了对当前语言模型在模拟文本世界方面能力的全面评估,并揭示了它们在这一任务上的局限性。

Q: 有什么可以进一步探索的点?

A: 根据论文的结论和局限性部分,以下是一些可以进一步探索的点:

- 更广泛的语言模型评估:论文中提到,尽管GPT-3.5和GPT-4是当时表现最好的模型,但并没有详尽地评估所有大型语言模型。未来的研究可以探索更多种类的模型,以确定是否有其他模型在模拟任务上表现更好。

- 不同的表示形式:论文中使用了JSON对象来表示状态空间。未来的工作可以探索其他表示形式,以确定是否有更有效的方式来表示和处理状态空间。

- 特定领域的模拟:论文中的实验主要集中在常识和初级科学推理任务上。未来的研究可以探索使用LLMs作为模拟器在更特定、更复杂的领域,如物理模拟或医学模拟。

- 改进的算法和架构:论文指出,当前的LLMs在模拟环境驱动的转换和需要算术、常识或科学知识的任务时存在困难。未来的研究可以探索改进的算法和模型架构,以提高这些领域的性能。

- 减少模拟错误的影响:由于模拟错误会随着时间的推移而累积,研究如何减少单步模拟误差的影响,或者如何设计能够自我纠正的模拟器,可能是一个有价值的研究方向。

- 伦理和社会影响:论文提到了LLMs在生成误导性或非事实信息方面的潜在风险。未来的研究可以更深入地探讨这些伦理问题,并开发策略来减轻这些风险。

- 教育和实际应用:论文建议LLMs作为模拟器的应用在教育和与儿童直接互动的环境中可能不安全。研究如何安全地将这些技术应用于教育和其他实际场景,将是一个重要的研究方向。

- 长期跟踪和评估:论文提出了一个基准测试来评估现有和未来的模型。继续维护和更新这个基准测试,以跟踪语言模型在模拟任务上的进步,将是一个持续的过程。

这些探索点可以帮助推动语言模型在模拟任务上的性能,同时确保这些技术的发展和应用是安全和负责任的。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容可以总结如下:

- 研究问题:探讨当前语言模型(LLMs)是否能够作为文本基础的世界模拟器,预测动作如何改变世界状态,从而减少手动编码的需求。

- 方法论:

- 构建了一个新的基准测试,名为BYTESIZED32-State-Prediction,包含文本游戏状态转换和任务的数据集。

- 提出了LLMas-a-Simulator (LLM-Sim)任务,用于量化评估LLMs作为模拟器的能力。

- 实验设计:

- 使用BYTESIZED32-SP数据集对GPT-4模型进行测试。

- 评估了模型在完整状态预测和状态差异预测两种模式下的性能。

- 主要发现:

- GPT-4在模拟动作驱动的转换方面表现相对较好,但在环境驱动的转换和需要算术、常识或科学知识的任务上表现不佳。

- 人类在LLM-Sim任务上的表现优于GPT-4。

- 结论:

- 尽管LLMs在某些方面有潜力,但目前还不能作为可靠的文本世界模拟器,需要进一步的创新。

- 局限性和伦理问题:

- 论文讨论了研究的局限性,包括评估的模型范围、表示形式的选择和任务类型的限制。

- 提出了使用LLMs作为模拟器可能带来的伦理和社会风险,并强调了负责任使用的重要性。

- 未来工作:

- 论文提出了对未来模型的评估和开发更高性能的语言模型模拟器的期望。

论文通过构建新的基准测试和对现有模型的评估,为理解LLMs在模拟任务上的能力提供了新的见解,并为未来的研究指明了方向。